Tenemos muy claro que gran parte del nuevo espectador de cine está cada vez más familiarizado con la nuevas tecnologías fílmicas. El cinéfilo siempre ha sido un alma devoradora de libros con un único objetivo, conseguir exprimir al máximo todas las facetas artísticas del lenguaje cinematográfico. Ahora está faceta parece olvidarse para centrarse únicamente en la calidad del visionado: las resoluciones, el HDR, los sistemas de sonido, la compresión, los lumens o el contraste son algunos de los elementos que los aficionados al cine debaten cada día en los foros de la web. De todo lo citado la resolución y el HDR parecen ser el caballo de batalla de la industria y por eso nos gustaría de forma breve y clara aportar un poco de luz a términos como analógico, digital, 35mm, 2K, 4K, HDR y la inminente en salas 8K.

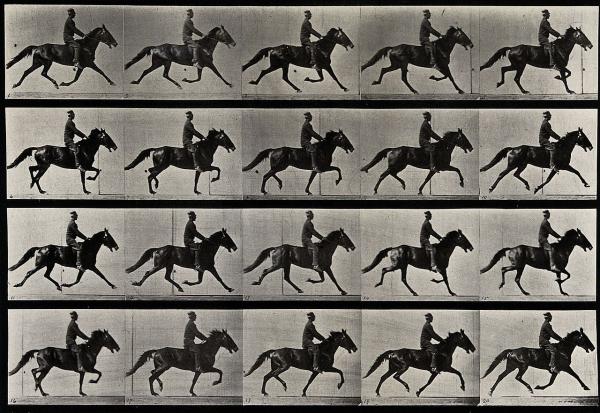

Caballo en movimiento (Animal locomotion) es una secuencia animada de un caballo de carreras galopando. Las fotos fueron realizadas por Eadweard Muybridge y se publicaron por primera vez en 1887 en Filadelfia.

El cine comienza el 28 de diciembre de 1895, los hermanos Lumière proyectaron públicamente la salida de obreros de una fábrica francesa en Lyon, la demolición de un muro, la llegada de un tren, y un barco saliendo del puerto.

Los inicios del cine digital datan de principios de los 80. En esos años ya se empredía un camino electrónico en el cine que mostraba efectos visuales nunca antes vistos. Ahora en este tiempo lo más común es ver una película 100% digital.

Esta revolución de la imagen digital nos habla del HD, FULL HD, 2K, 4K e incluso Sony y Panasonic ya tienen en su mira una futura resolución de 8K, lo que quiere decir que 2K es igual a una resolucion de 2048 x 1080. 4K son resoluciones de 4096 x 2160. Y 8K resoluciones maximas de 8192 × 4320 que equilvadrían casi a la percepción del ojo humano.

Sony se lanzaba a comercializar el concepto de “cine digital” ya a finales de los 80, usando cámaras HDTV analógicas basadas en tubos, con más bien poco éxito en un principio. No fue hasta 1998, al ser capaces de desarrollar y comercializar cámaras CCD manejables de 1920×1080 pixeles que incluían grabadoras HD Digital Betacam, cuando la industria comenzó a tomarse en serio este nuevo medio.

En los 90, el cine comenzó un proceso de transición del soporte fílmico a la tecnología digital. Aunque el primer film con efectos especiales digitales fue Tron, ya en 1982, no fue hasta mediados de los años noventa cuando la tecnología digital desembarcó en la industria cinematográfica de forma habitual. Mientras, en el ámbito del vídeo doméstico, surgió otro soporte digital, el DVD que aparece como nuevo estándar.

El cine frente al Celuloide

El cine digital ha generado abundantes disputas en torno a la naturaleza intrínseca del cine. Las posturas van desde los entusiastas que ven en la tecnología digital la panacea y los avances que el lenguaje cinematográfico venía solicitando desde hace mucho tiempo (como el popular George Lucas), hasta los detractores más acérrimos que ven en el digital la pérdida de la esencia de la mirada fílmica (como los directores españoles Víctor Erice o José Luis Guerín). Se ha dicho incluso que el cine digital supone otra clase de experiencia visual totalmente distinta al cine grabado químicamente y proyectado mecánicamente. En cualquier caso, la evolución ya ha empezado y aunque películas como El Despertar de la Fuerza o Los Odiosos 8 siguen siendo filmadas en celuloide, la mayoría de producción fílmica o televisiva está ya más que centrada en el digital.

Algunos puristas argumentan que el digital no consigue la misma “sensación” que una película grabada en celuloide. Aunque esto es una materia de preferencias personales más que otra cosa, las cámaras digitales han evolucionado rápidamente y la calidad se incrementa drásticamente de cada generación de hardware a la siguiente pero aun así no logran imitar ni asemejarse al celuloide en resolución y naturalidad. También existe el contra-argumento de que al pasarse la mayoría de películas de nuevo a rollo de película para su proyección en las sales, la “sensación” del celuloide retorna a la audiencia. Aunque, al menos en la actualidad, las cámaras digitales no pueden alcanzar el mismo nivel de calidad de imagen que un filme de 35 mm, hay quien piensa que el color y la claridad son mejores en digital. Aunque datos parecen cerciorar que aún no es así.

A finales del siglo pasado, numerosos directores notables declararon haberse “convertido” al cine digital y que nunca volverán a usar filme tradicional, entre los que se incluyen George Lucas, Robert Rodríguez, David Fincher, David Lynch, Lars von Trier o James Cameron. Algunos, como James Cameron y George Lucas, incluso declararon públicamente que jamás volverían a rodar con película tradicional. Otros, como Steven Soderbergh o Michael Mann, aunque no han llegado tan lejos en sus declaraciones, han grabado de forma experimental parte de sus últimas películas en digital. En el extremo opuesto, directores tales como Steven Spielberg, Martin Scorsese, Quentin Tarantino, Tim Burton, Ridley Scott o Oliver Stone, defienden continuar realizando películas con filme tradicional e incluso opinan que nunca podrá ser superado por la tecnología digital. Otros directores, como Víctor Erice o José Luis Guerín, especialmente los dedicados a un cine más minoritario, también se sitúan como acérrimos defensores del celuloide y sin embargo ruedan sus últimas películas con cámaras digitales, puesto que no pueden asumir los costes del analógico.

Atrapar la luz o interpretar el entorno: cine analógico vs digital

Robert Richardson, director de fotografía de la película “Los odiosos ocho” durante el rodaje.

[dropcap]E[/dropcap]n una silla, de espaldas a un paisaje montañoso, una pintora recrea en un lienzo la naturaleza que tiene detrás. Para ello le van otorgando una descripción precisa al milímetro, consiguiendo una interpretación exacta. Por otra parte otro pintor coge el lienzo y decide arrastrarlo por la hierba, las rocas y el cielo dejando que los colores y formas del paisaje se fundan directamente con el lienzo, atrapando su esencia y sus colores directamente del objeto que pretende pintar.

Quizás es una metáfora un tanto romántica, pero podríamos decir que introduce y expresa la esencia del cine digital y analógico y sus diferentes maneras de interpreta la realidad, el cual es el tema que quiero compartir en esta ocasión ya que desde hace unos años está habiendo un resurgimiento del analógico.

El cine es uno de los artes que más innovaciones ha recibido en las últimas décadas, por su estrecha relación con las innovaciones tecnológicas que ha traído la era digital. Allá por el principio del nuevo milenio comenzaba la conversión hacia el cine digital y poco a poco los cines se adaptaron, al igual que las productoras. Este método revolucionario cambiaba todo, desde la concepción de un rodaje hasta su coste, su producción y su postproducción, creando promotores y retractores que a día de hoy (afortunadamente) siguen existiendo. Actualmente, sobretodo en la música y el mundo del videoclip, se está acudiendo al efecto “vintage” de los ochenta y noventa. Prácticamente todos los videoclips en los últimos años acuden a esa estética, con una relación de aspecto de 4:3 en todos ellos y un falso o verdadero grano analógico.

Las ventajas son claras. El coste de las producciones se redujo notablemente debido al excesivo coste de la película. A su vez su almacenamiento se volvió mucho más sencillo y la posibilidad de borrar un clip rompió con uno de los mayores problemas del celuloide. Su edición se volvió más sencilla y a su vez ha democratizado la posibilidad de hacer cine. Eso puede parecer un problema o una amenaza para los y las cineastas ya que “cualquiera puede hacer cine”, aunque en mi opinión David Lynch ya lo dijo: “Aquí todo el mundo tiene lápiz y papel. Pero, ¿cuántas historias buenas se han escrito con ese lápiz y papel? Pues lo mismo va a pasar con el cine”. Hoy en día es fácil conseguir una cámara, lo que no es tan fácil es conseguir una buena historia que contar.

Son muchas y muchos los cineastas que prefieren acudir a la imagen analógica, aunque pocos pueden permitírselo. El por qué acude a muchos factores, en primer lugar la calidad. Existen formatos (sin acudir a tecnicismos) que permiten capturar una imagen con una calidad y con un espectro de color muy superior a lo que permite lo digital a día de hoy. Eso conlleva un mayor desembolso de dinero en la producción y por eso son pocos los que pueden permitírselo, pero existen directores consagrados como Tarantino o Christopher.

Frame extraído de la película “Dunkerque” de Christopher Nolan.

Por otra parte el famoso “grano” que proporciona por naturaleza la película, es uno de los factores diferenciales. Guste más o menos, crea una estética distinta, como si hablásemos de dos estilos de pintura diferentes, y a mí personalmente le otorga una profundidad y un alma superior. Y es que como el propio título del artículo dice, son dos maneras distintas de retratar la realidad. Una se basa en la interpretación matemática y el otro se basa en la captura de la luz. De una manera la cámara interpreta mientras que de la otra está capturando literalmente a través de la luz lo que tiene delante.

Quizás para muchos sea la diferencia entre un CD y un vinilo, o no le suponga un aspecto importante o diferencial a la hora de ver una pieza audiovisual, pero si la luz y el color cambian, para mí todo cambia.

Tipos de cámaras

Las cámaras de Sony CineAlta eran (y son), básicamente, las cámaras de alta definición descendientes de las Betacam, dirigidas a la producción cinematográfica. Así como los estándares NTSC y PAL, pueden reproducir 29.97 y 25 imágenes por segundo respectivamente, estas pueden grabar las mismas 24 imágenes por segundo. Sus sensores CCD tienen una resolución de 1920×1080 píxeles (1080i de entrelazado en inglés o 1080p de progresivo). Comparando, algunos escáners de filme analógico son capaces de capturar más de 10.000 píxeles horizontalmente desde una película estándar de 35 mm. El Episodio III de Star Wars se grabó con las cámaras más avanzadas de la serie CineAlta, el modelo HDW950, con una resolución de 1920×1080 píxeles por fotograma.

Panavisión lanzó en 2004 las cámaras Panavisión Genesis para competir con las CineAlta de Sony. Las Genesis consiguen una resolución de 1920×1080, similar a la de sus predecesoras, y utilizan un sistema de cinta parecido, pero utilizan un sensor CCD con la misma medida que una cámara estandar tradicional de 35 mm, lo que le permite una serie de ventajas como poder intercambiar objetivos con las cámaras tradicionales o conseguir un control muy similar sobre la profundidad de campo. Algunas películas famosas rodadas con cámaras Genesis fueron Superman Returns, Flyboys o Scary Movie 4, a la cual se le criticó la calidad de las imágenes, lo que se atribuyó a la alternancia de la cámara digital y una tradicional de 35 mm.

Las Arriflex D-20 apareció a finales del 2005. La única novedad de esta cámara era su tamaño y tipo de sensor: en lugar de un CCD convencional, utilizaba un sensor CMOS con la misma medida que el de una cámara analógica de 35 mm. Esto le permitía usar las mismas lentes, abarcar el mismo campo de visión y conseguir la misma profundidad de campo que una cámara tradicional. La Arriflex alcanza una resolución de 1920×1080 pixeles.

Ya más actual, la Red One es una cámara desarrollada por parte de la RED Digital Camera Company. Graba en 2K y 4K 4520 X 2540, Tiene Un Sensor cmos De (12 megapixeles), a hasta 60 cuadros por segundo (progresivos en todos los casos, y programable por el usuario – por ejemplo puedes obtener 24fps como en el cine, o los cuadros por segundo que desees), mediante un sensor lo bastante grande como para adaptar la lente de una cámara analógica de 35mm. Se proyecta como la más apetecida por productores independientes, ya que su precio es de 7 a 10 veces menos que sus competidoras, (precio u$17.500, solo cuerpo). y a precios que no son los usualmente astronómicos de esa industria. Así mismo el vídeo es grabado en formato RAW con 12 bits por color (36 bits) para un rango dinámico como al que estamos acostumbrados a ver en películas de cine.

Con ella se han rodado escenas en Películas como:

- Crossing the Line (2008, completa en RED ONE)

- Jumper (2008)

- Knowing (2009, completa en RED ONE)

- Ángeles y demonios (2009)

- Night at the Museum: Battle of the Smithsonian (2009)

- District 9 (2009, completa en RED ONE)

- Gamer (2009, completa en RED ONE)

- The Informant! (2009, completa en RED ONE)

- Desde mi cielo (2009)

- The Book of Eli (2010)

Ahora mismo podemos hablar ya de las 8K con modelos como la Panavision Millennium DXL de Panasonic, quien no tiene problema para trabajar con el formato 8K, entre otras virtudes.

Aunque se le podrán dar mil aplicaciones, es una cámara ideada para cine y tiene un sensor de generoso tamaño – 41 x 26 milímetros -, desarrollado por la gente de RED. Ahí dentro caben 35,5 megapíxeles, que como podréis imaginar son números muy llamativos para un equipo ideado para vídeo.

Parándonos en el vídeo hay que destacar que no solo es que grabe contenidos en formato 8K, sino que es capaz de registrarlos a una tasa de 60 imágenes por segundo (15 pasos de rango dinámico). El contenido se puede grabar directamente en SSD, tanto 8K RAW, como 4K Apple ProRes, o Avid DNX.

Parece obvio que lo que aquí interesa es registrar el contenido a mayor calidad posible para que llegue a edición en las mejores condiciones. Pero también introduce cosas para que el flujo de trabajo sea más dinámico, por ejemplo, mecanismos para trabajar el color directamente en la cámara. Este tema está desarrollado de forma conjunta con los especialistas en post-production de Light Iron.

Esas dimensiones le permiten a la DXL trabajar con un modo anamórfico en 4K, la primera cámara que dicen que es capaz de hacerlo. Ese formato propone crear contenido panorámico a partir de una proporción más cuadrada, a través de objetivos especiales. Como hay realizadores que siguen utilizando la técnica y esos objetivos, tiene sentido que una cámara lo ofrezca.

Otro modelo 8K, es la cámara RED Weapon 8K, ideal para captar imágenes a gran resolución que luego pueden proyectarse sin problemas en una sala IMAX.

Nik Korda, productor ejecutivo de Guardianes de la Galaxia Vol. 2 (primer film rodado en 8K), explicó por qué usarán esta cámara de la empresa RED: “La súper alta resolución que ofrece la nueva Weapon 8K, combinada con su peso liviano y tamaño compacto, ofrece toda una nueva gama de posibilidades creativas”.

Otras de las ventajas de la Weapon 8K es que puede filmar a 75 cuadros por segundo e incluso, si la cámara se ajusta a 4K, puede llegar a capturar imágenes a 150 cuadros (el estándar en el que vemos películas desde hace más de 60 años es 24 cuadros por segundo).

Época de transición fílmica

Aunque el digital gana enteros cada día, todavía estamos en una época de transición. No hace mucho tiempo, cada vez eran más las producciones que se atrevían a rodar las películas en fotoquímico para posteriormente utilizar un sistema de postproducción digital. Se trata del Intermediate Digital (ID), un proceso ya habitual en nuestro país y que fue cobrando más peso en los sistemas de postproducción. En EEUU el 80 por ciento de las películas siguen el proceso del ID; en España, aunque ese porcentaje no es tan amplio, va creciendo a pasos agigantados.

Pero, ¿por qué postproducción digital si se rueda con película fotoquímica? Hoy día -y hasta el momento de escribir este artículo-, ningún sistema de registro digital llega a aportar la información (cantidad y calidad) que ofrece un negativo de 35mm. Aune se desarrollan sensores cada vez con más resolución, la textura no es todavía la que sería deseable. Las cámaras de Cinealta de Sony y Viper de Thompson están provistas de unos CCD de 2/3 de pulgada, que no llegan a matizar todos los detalles que ofrece la película de 35mm; sobre todo, con los avances que se están produciendo en el ámbito fotoquímico.

El escáner o digitalización | Comparando resolución química y digital

Es el proceso mediante el cual se convierte una imagen analógica (fotoquímica) en información digital (ceros y unos del código binario). Es un proceso clave para todo el trabajo que le siga a continuación, ya que dependerán de la calidad de este escáner el resto de fases hasta llegar de nuevo a una imagen fotoquímica. El tamaño de una imagen digital se mide en miles de píxeles de resolución horizontal. Un “K” significa 1.024 píxeles. Un 4K tiene 4.096 píxeles de resolución horizontal, y 3.112 píxeles de resolución vertical. La resolución de la imagen más habitual es 2K (aunque canales como Netflix ya han empezado a despegar el 4K HDR), una resolución en píxeles de 2048 x 1556 en un fotograma escaneado a toda ventanilla (full aperture). El tamaño de un fotograma de estas dimensiones, es de más de 12 megabytes. A razón de 24 fotogramas por segundo, imagínense la cantidad de megas, gigas y teras que puede tener una película…

¿Cómo comparamos, entonces, las resoluciones digitales comparada con la resolución de la película cinematográfica? Teóricamente, basado en la estructura del grano de la emulsión, la película en 35mm puede tener una resolución equivalente a un 6K. En la práctica, esto sólo es cierto para el negativo de primera generación (es decir, el negativo de cámara) y bajo condiciones idóneas. Sin embargo, un negativo se supone que en la práctica no supera la resolución de 4K. Hay quien dice que las copias de exhibición hechas desde un internegativo, y proyectada en los cines comerciales, no llegan a tener una calidad superior a los 2K, por los procesos -y sucesivas generaciones- a los que se ha sometido hasta la proyección final.

Sin duda 2013 supuso el pistoletazo de salida oficial del denominado “4K“, y en el 2016, esto se confirma con la producción televisiva.

¿Que es el “4K” exactamente?

El vocablo 4K hace mención a la resolución 4K, la cual es, para simplificar, el doble de ancha y de alta que la resolución FullHD (1920×1080) o también “2K”, con CUATRO veces más información visual.

A nivel de resolución, equivaldría a aproximadamente a 3996 × 2160 píxeles, de ahí que también se le denomine 2160p por las líneas horizontales, al igual que al FullHD se le denomina 1080p. Existen más resoluciones dentro del formato 4K (y del 2K), pero esa es la que se aplica a cine digital en formato “Flat”. Es tan sencillo como multiplicar 1998×1080 por dos…

Ciertamente pudiera parecer que el “4K” es una moda loca que ha llegado de repente, cuando en realidad lleva con nosotros un tiempo. El problema es que tal resolución no era fácil de manipular. Por ejemplo, los negativos de 35mm se suelen escanear a resolución 4K o superior, para así luego eliminar impurezas (suciedad, pelos, etc), re-etalonar (ajustar el color de la imagen) y generar un master en 4K del cual luego se finaliza en 2K. Eso en los casos más extremos, pues generalmente el archivo suele ser en 2K, lo cual puede que sea una mala idea, pues hay películas que se han vuelto a re-escanear y el coste a veces no es ya prohibitivo, sino que ese negativo de 35mm estaba más deteriorado…

Claro, estamos hablando del cine analógico, sin embargo el cine digital, pese a su concepción y naturaleza, no ha llegado a las resoluciones 4K hasta hace relativamente pocos años.

Afortunadamente, la llegada de la TDT y la posterior reconversión de las cadenas hicieron que cada vez hubiese más contenidos disponibles en HD. Eso sin mencionar el Bluray, que navegaba y navega aún entre aguas al tener que luchar contra un parque enorme de reproductores DVD y los modernos Media Players basados en archivos digitales.

Así con todo, parecía que esos experimentos de los Japoneses con eso de UHDTV (Ultra Alta Definición o 4K) quedaban muy lejos…hasta ahora, claro.

Con la llegada de la cámara RED ONE, se abrió un enorme mundo, que al principio no pudo ser explotado. La cámara ciertamente grababa en 4K, pero el procesado y la edición de los ficheros era muy pesado para los equipos de la época y sólo grandes equipos (y muy caros) podían editar “más o menos”. La inmensa mayoría editaba en 2K. Mayormente porque el incipiente Cine Digital, pese a permitir la resolución 4K, a nivel de proyección era en 2K.

Con el paso de los años, y en muy poco tiempo, el panorama ha dado un vuelco enorme. Los ordenadores cada vez más potentes (y más económicos), los sistemas de edición cada vez más eficientes, y la llegada del floreciente mundo HDSLR hizo impulsar un nicho de mercado emergente hasta cotas que nadie podría preveer. Pero así ha sido.

En el mundo más High-End, las cámaras de Cine Digital se enfrascaban en una lucha por ofrecer el “más todavía”. Sin embargo, no nos engañemos, los equipos eran todavía caros.

Hasta la llegada de Black Magic el 8 de Abril de 2013, que presentaba una cámara 4K por 3999$ poniendo a disposición de “casi cualquiera” las herramientas de las hermanas mayores.

Mientras esperamos que los nuevos dispositivos 4K acaben por asentarse (ya lo están, tanto Samsung como Philips, Sony, Panasonic, LG, y demás ofrecen modelos 2018 4K HDR de 55″ a menos de 700€). ¿Quién en su sano juicio editaría en 4K teniendo en cuenta que pocos podrán ver tan tremenda resolución? Pues Netflix y Amazon como pioneros y parece que ya el resto del planeta (hasta RTVE emite pruebas en 4K).

Una de las importantes bondades digitales de disponer de una mayor imagen es el hecho de estabilizar la imagen. Al realizar una estabilización digital, se pierde calidad. Al realizarla sobre una imagen en 4K, no perdemos nada, pues al escalar luego a 1080P/2K, seguimos teniendo resolución de sobra.

No olvidemos que además, los Timelapses que sacamos con nuestras cámaras de fotos tienen incluso MAS resolución que la de una cámara 4K. Ya de base estamos trabajando en 4K, sin saberlo 🙂

Así, ¡Bienvenido el 4K!.

Los proyectores de cine y los 24 Fotogramas

Un proyector cinematográfico es un dispositivo opto-mecánico empleado para mostrar películas al proyectarlas en una pantalla. La mayoría de los componentes ópticos y mecánicos, excepto los concernientes a la iluminación y al sonido, están también presentes en las cámaras cinematográficas.

La máquina proyecta, a intervalos regulares de pocas centésimas de segundo, un haz de luz sobre los fotogramas de una película; ese haz de luz viene aumentado e invertido por una lente que enfoca la imagen resultante sobre una pantalla.

El cinematógrafo fue patentado en febrero de 1894 por los hermanos Lumière y las primeras exhibiciones públicas se realizaron en 1895. En la actualidad existen “proyectores cinematográficos digitales” que proyectan una imagen generada por medios digitales, sin hacer uso de una película, pero sí del haz de luz y de las lentes.

Desde el nacimiento del cine sonoro, casi todos los proyectores de cine comerciales proyectan a una frecuencia de 24 imágenes por segundo (a partir de 16 fotogramas el ojo humano ya detecta movimiento continuo como demostraban las proyecciones domésticas). Esta velocidad se eligió por razones financieras y técnicas: era la frecuencia más baja (por lo que requería menor cantidad de película) a la que se podía realizar una reproducción y amplificación del sonido satisfactorias. Hay sin embargo algunos formatos especiales como Showscan o Maxivisión que proyectan a frecuencias más altas, a menudo 48 imágenes por segundo.

Las películas mudas normalmente no se proyectaban a velocidades constantes, sino que variaban durante la proyección a discreción del proyeccionista, a menudo de acuerdo con notas proporcionadas por el distribuidor.

El cine y la televisión siempre han estado en disputa desde que los televisores llegaron a los hogares en los años 1940 y 1950. Se puede decir que por esta razón el cine cambio su proporción (fullscreen a widescreen) con el propósito de atraer espectadores. Sin embargo la televisión tuvo tanto éxito que obligó a las casas peliculeras a reinventarse para que así la gente se moviera a los cines en lugar de quedarse en sus hogares. Por esta y otras razones surgió la proyección digital.

El proyector digital usa la tecnología DLP basada en espejos que se mueven reflejando la luz con diferente intensidad y color. Los proyectores que se están instalando en todo el mundo son de 2K (2048 x 1080), aunque también hay de 4k (4096 x 2160) en desarrollo. La calidad del cine analógico en soporte 35mm sería apróximadamente de 8k, por lo que el digital no llega a equiparársele, aunque tiene otras ventajas como la calidad de la proyección no se ve deteriorada con el tiempo, no se raya, tiene mejor brillo y tiene la posibilidad de proyectar contenidos de TV, DVD, Blu-ray, así como la posibilidad de la proyección en 3D, al ser instalados sistemas de filtros de polarización de imagen, como RealD 3D, Dolby3D, o XpanD, entre otros.

Para proyectar contenido digital los proyectores reciben la señal de un servidor o SMS (Screen Management System), el cual es una computadora a la cual se le ingestan los DCP (digital cinema package) que son los spots, trailers o películas, o bien pueden recibir la señal desde un DVD, Blu-ray, HD-Cam, etc.

Las normas internacionales que regulan este sistema son DHI. Las marcas de proyectores digitales más avanzadas son Barco, Christie, Cinemecánica, Kinoton, Sony, Victor Company of Japan, y utilizan tecnología de Texas Instruments.

Y ahora el HDR

Artículo recogido de www.timelapses.es

Sin duda la llegada de la proyección digital al mundo del cine ha supuesto una gran cantidad de avances tecnológicos que nos permiten ver las películas de forma diferente a lo que habitualmente existía. El uso del 3D, el HFR (High Frame Rate), la resolución 4K con una nitidez nunca antes vista, la proyección laser (que ya empieza a implantarse), el sonido multicanal avanzado (ATMOS, IMMSOUND, AURO) y las experiencias 4DX (Butacas con vibración, movimientos y efectos de sonido sincronizados con la peli) suponen una experiencia “premium” para el que quiera “ir más allá”.

Pero la industria no para, y el próximo objetivo se centra en ofrecer una imagen más allá de lo visto, con unos niveles e intensidad de luz superiores a todo lo visto. Se denomina HDR (High Dynamic Range) y es un “viejo conocido” en la industria, que quiere jugar en la mayor liga. ¿Lo conseguirá?. En ello están…

¿QUE ES EL HDR?

Bueno, sintetizando MUCHO, se trata de una imagen cuya “intensidad” de imagen supera con mucho las imágenes habituales en 8/10/12 bits. Dado que tenemos más RANGO DINAMICO VISIBLE, accedemos a imágenes mucho más luminosas donde deben serlo (brillos, reflejos, sensación de “realidad”) y con negros absolutos (similares a las pantallas OLED).

Los primeros pasos para ver como implementar algo tan técnicamente complejo como el HDR en la proyección Digital comenzó en una reunión de la CinemaCon, la convención de la NATO (National Association of Theatre Owners).

Las conclusiones de dicha reunión es que en algunos experimentos realizados, se usaron proyectores Laser para tratar de extender la colorimetría, mientras que otros trataron de usar proyectores normales pero intentando obtener un “blanco más brillante”, más allá de los 14 FL (Foot Lamberts) y negros más intensos.

Por otro lado, existe una preocupación sobre las consecuencias de una sobre-expectación que tendría el formato y sobre las cantidades de versiones a ser distribuídas. Así, debería haber un sitio donde reunirse y poder establecer una serie de límites que guíen a la industria para sacar nuevas soluciones, pero no crear nada que luego no pueda sostenerse en el tiempo. La propuesta debe ser sólida y REAL.

Los estudios no están por la labor de distribuir un montón de versiones diferentes (como ya pasa actualmente, con versiones 2D, 3D, 2K, 4K, HFR, audios en 5.1, 7.1, ATMOS, DBOX, etc)

Por otro lado, existe trabajo ya adelantado sobre esta cuestión. El grupo “Next Gen” de la Academia de Cine ya ha capturado las primeras imágenes de test en formato HDR. Sin embargo, existe una gran duda de como ver un material sobre un Hardware que no está adecuado a ello. Es decir, tratar de ver material HDR en un proyector que SOLO tiene 12bits de profundidad, es inviable.

Se está tratando de encontrar proyectores especiales de posproducción que puedan mostrar todos los rangos posibles que buscan.

La DCI ya ha remasterizado el contenido a varios niveles de HDR y estará disponible tan pronto encuentren una casa de post-producción que pueda manejar ese material.

Uno de los estudios comentó que hay que asegurarse que participen en este proceso exhibidores, directores, directores de fotografía, estudios, fabricantes, etc…para establecer un consenso común en la estandarización de un espacio de color.

Uno de los potenciales problemas viene con la proyección laser, que incrementaría el rango dinámico de tal forma que serían necesarias diferentes versiones de HDR. Así mismo es necesario un proyector de referencia.

Se deben saber cuales son los objetivos, porque en última instancia los fabricantes necesitan saber lo que deben construir, y las casas de masterizado saber lo que deben preparar.

Desafortunadamente, no se sabe a ciencia cierta si algún proyector podrá ofrecer gamuts ampliados a EDR-HDR en un par de años, y es demasiado pronto para tener un proyector de referencia debido a los cambios de tecnología en constante cambio. La DCI no obstante ha estado pensando y realizando pruebas al respecto, así que es el momento exacto para empezar a ponerse en serio.

Otro Estudio comentó que estamos en el principio. No se puede realizar un estándar hasta saber lo que es posible hacer.

Por otro lado, la socialización y la educación a través de la industria es necesaria. Los exhibidores deben saber que esta nueva propuesta NO reemplazara el equipamiento que han adquirido recientemente. Y es que los Exhibidores piensan que adquirir una nueva tecnología es siempre sinónimo de gastar.

En realidad, se trata de una oportunidad de los Exhibidores para ofrecer una experiencia PREMIUM. Esto requerirá un master especial, diferente al normal. El concepto de tener una versión especial HDR está bien, pero si hay que tener 10 o 12 versiones diferentes para cada fabricante, puede ser una pesadilla. Cada espacio de color y luminancia requerirá un nuevo master.

Si queremos UN solo nuevo master, entonces hay que elegir un nuevo espacio de color y una luminancia standard, con su lógica pequeña variación en proyección. Con estos datos, necesitaremos un objetivo de fecha. Y una vez fijado el objetivo, tendremos que pensar si hay que redefinir el nuevo DCDM (Digital Cinema Digital Master).

Por supuesto, debemos estar seguros de que el contenido podrá reproducirse. Un DCP a 500mbit/sec no puede reproducirse en equipos antiguos, y tenemos que tener en cuenta ese handicap. Y es demasiado pronto para saber o decir exactamente que bitrate será necesario para HDR-EDR.

Más allá del HDR, una de las discusiones más importantes es la potencia de luz para la alta intensidad de brillo necesaria. Cientos de cines IMAX están proyectando a 22FL, especialmente en 2D. El contenido está remasterizándose por IMAX para este brillo tan potente. Podemos usar esos cines como guía para establecer el nuevo sistema y que sea comercialmente viable.

Uno de los grandes problemas en los cines es la LUZ AMBIENTE, que mata la relación de contraste a esos niveles requeridos. Y sobre todo tener en mente el cambio de luz que se produciría entre 2D y 3D en HDR.

El ISDCF es el grupo ideal para ayudar a definir los requerimientos operativos para el masterizado, distribución y reproducción. Otros grupos podrían realizar trabajo colaborativo, como la DCI.

Está claro que la proyección laser y HDR es el combo perfecto. Sin embargo, existe una corriente de opinión de que lanzar los nuevos proyectores Laser sin la consideración de que no sean HDR podría ser claramente un paso el falso para los primeros cines que adopten esta tecnología y luego tengan que cambiar de nuevo de proyector.

HDR será un formato de distribución especial, por lo que HDR y las tecnologías actuales estarán al mismo tiempo en el “campo de juego”.

Existen proyectores que se están vendiendo actualmente que “dicen” estar preparados para HDR

Por otro lado, los fabricantes están actualmente vendiendo proyectores Laser.

Así, pensar que los proyectores laser no deberían venderse hasta solventar el tema del HDR no es realista. Crear un Standard basado en reglas de Marketing antes de realizar una investigación básica no es sabio. El tiempo es la esencia.

Los fabricantes de TV ya están en este camino, creando televisores LED 4K HDR.

Actualmente, los fabricantes están eligiendo el Laser basados en sus requerimientos individuales, y no queremos crear una versión para cada proyector laser, con lo que no hay ninguna razón para que todos los fabricantes de proyectores laser se pongan de acuerdo en un punto común para evitar tener que realizar diferentes masters.

• Sobre el tema de la operativa acerca de la captación de la imagen, las demostraciones realizadas tanto en la ASC como en la Academia revelan que existe una operativa diferente. Por ejemplo, no es necesario extraer las reflexiones fuera de la escena o set.

Mirando el contenido de películas que han sido rodadas sin el conocimiento del HDR, existe un montón de información que se perdió de los ficheros EXR cuando se hizo el DCP. Es un poco como trabajar directamente con en negativo en vez de la película impresa. Esto significa que se puede volver atrás en contenidos ya existentes y poder restaurar información que no es visible actualmente.

La Academia ha estado trabajando en este tema desde hace 10 años con la idea de que el HDR llegaría y hay un ferviente deseo de moverse a negativos HDR de 16bits. Hay progresos pero está llevando más tiempo de lo que se esperaba.

De momento a nivel doméstico ya se ha cerrado el llamado UHD Premium que lleva las siguientes característica:

Image Resolution: 3840×2160

Color Bit Depth: 10-bit signal

Color Palette (Wide Color Gamut)

Signal Input: BT.2020 color representation

Display Reproduction: More than 90% of P3 colors

High Dynamic Range

SMPTE ST2084 EOTF

A combination of peak brightness and black level either:

More than 1000 nits peak brightness and less than 0.05 nits black level

OR

More than 540 nits peak brightness and less than 0.0005 nits black level

Y como hemos dicho a lo largo del artículo, canales como Netflix o Amazon ya han empezado la producción en este formato. Concretamente, es la segunda temporada de la serie Marco Polo quien ha iniciado el 4K HDR en el canal Netflix, al que le van a seguir la mayoría de producciones aunque eso sí, en España todavía no hemos podido ver y por tanto clarificar, cual es la calidad real de estas siglas que a veces pueden ser más de índole comercial que de valor real.

Por supuesto el vídeo doméstico no se queda atrás y el UBD o Ultra Blu-Ray también está ya entre nosotros con películas ya editadas como éxitos comerciales de la talla de Mad Max: Furia en la Carretera, Sicario o San Andreas, todas en 4K HDR.

No nos olvidamos de la Realidad Virtual RV, la cual ya empieza a hacer sus pinitos en pequeñas producciones audiovisuales y con ideas de presentarse como una posible sala de cine en casa con pantallas virtuales de hasta 300″.

Comparación entre Nits, Lúmenes y Luminancia: Métricas de Brillo en Pantallas Electrónicas

En el ámbito de las pantallas electrónicas, es común encontrarse con términos como nits, lúmenes y luminancia, los cuales pueden generar confusión. Estas métricas desempeñan un papel fundamental al evaluar el rendimiento visual de dispositivos como televisores, smartphones y monitores. En este artículo, vamos a explorar las diferencias entre estos conceptos y aclarar su significado en el contexto de la electrónica moderna.

Nits

Los nits representan una medida utilizada para cuantificar el brillo de las pantallas electrónicas, especialmente las de tecnologías emisoras como LED, OLED y microLED. Un nit equivale a una candela por metro cuadrado (cd/m²), siendo la candela la unidad estándar para medir la intensidad luminosa. Por lo tanto, los nits indican la cantidad de luz emitida o reflejada por una pantalla en un metro cuadrado.

Lúmenes

Por otro lado, los lúmenes son una unidad de medida utilizada para describir la cantidad total de luz visible emitida por una fuente luminosa. A diferencia de los nits, que se enfocan en el brillo superficial de una pantalla, los lúmenes miden la potencia luminosa global de un dispositivo. Esta medida es comúnmente empleada en la evaluación de proyectores, linternas y otras fuentes de luz, aunque no es directamente aplicable a la medición del brillo de las pantallas.

Luminancia

La luminancia se refiere a la cantidad de luz que una superficie emite, refleja o transmite por unidad de superficie. Se expresa en candelas por metro cuadrado (cd/m²) o nits, lo que la vincula estrechamente con el concepto de nits. La luminancia considera diversos factores, como el brillo de la fuente de luz, la reflectividad de la superficie y la posición del observador. En el contexto de las pantallas, la luminancia indica la intensidad de la luz emitida por una pantalla en particular.

Diferencias y Aplicaciones

Aunque estas tres métricas están relacionadas con el brillo de las pantallas, sus aplicaciones e interpretaciones difieren significativamente:

Los nits se utilizan principalmente para medir el brillo de las pantallas emisoras, como televisores y smartphones. Valores más altos de nits indican pantallas más brillantes, lo que garantiza una mejor visibilidad en entornos bien iluminados o bajo luz solar directa.

Los lúmenes se emplean para evaluar la cantidad total de luz emitida por una fuente luminosa, pero no son directamente aplicables a las pantallas. Son más relevantes para proyectores, linternas y dispositivos de iluminación en general.

La luminancia abarca mediciones en nits y cd/m². Es una métrica global que considera la intensidad de la luz emitida por la superficie de una pantalla, teniendo en cuenta factores como el brillo, la reflectividad y las condiciones de visualización. La luminancia es crucial para determinar el brillo percibido por el espectador.

Importancia Práctica

Entender estas métricas es esencial al elegir el dispositivo de visualización adecuado para aplicaciones específicas. Por ejemplo, un índice de nit más alto en un smartphone garantiza una mejor visibilidad en exteriores con mucha luz. Del mismo modo, un televisor con alto nivel de nits y una buena luminancia es ideal para salas bien iluminadas, evitando imágenes apagadas y manteniendo colores vibrantes.

Es importante destacar que, si bien valores más altos de nits o luminancia suelen indicar una mejor visibilidad, niveles de brillo excesivamente altos pueden causar fatiga visual en entornos oscuros. Ajustar la luminosidad a las condiciones de luz ambiental es esencial para una experiencia visual cómoda y saludable.

Conclusión

En conclusión, los nits, los lúmenes y la luminancia son métricas esenciales para evaluar el brillo en pantallas electrónicas. Comprender las diferencias y aplicaciones de estas métricas permite a los consumidores tomar decisiones informadas al seleccionar dispositivos que satisfagan sus necesidades específicas de luminosidad.

Estas métricas también son importantes en diversos sectores más allá de la electrónica de consumo:

En aparatos electrodomésticos, se necesitan pantallas legibles en diferentes condiciones de iluminación.

En dispositivos industriales, se requieren pantallas que resistan entornos difíciles y permanezcan visibles bajo luz intensa.

En dispositivos militares y marinos, las pantallas de alto brillo son cruciales para una visibilidad clara en exteriores y con luz solar directa.

En dispositivos médicos, la visualización precisa es esencial para diagnósticos precisos y procedimientos quirúrgicos, por lo que se requieren pantallas con altos nits y luminancia.

Seleccionar pantallas con los valores adecuados de nits, lúmenes y luminancia es esencial para garantizar un rendimiento óptimo en diversos entornos profesionales. Es importante consultar con expert

Final

Y así cerramos un artículo sobre el futuro del cine y la televisión, pero antes, nos gustaría dar las gracias a lugares como timelapses.es donde hemos podido recoger gran información sobre el tema y otros blogs o webs similares y por supuesto a la wikipedia, lugar ideal para este tipo de artículos.